1. 数据流概念

数据流是一种在连续时间序列中,以流的形式不断产生和消费数据的模型。它由一系列有序的数据元素组成,每个元素具有特定的属性和值。在数据流中,数据元素按照时间的顺序依次出现,且每个元素只出现一次。与传统的批处理数据不同,数据流具有实时性、连续性和流式性的特点。

2. 数据流模型

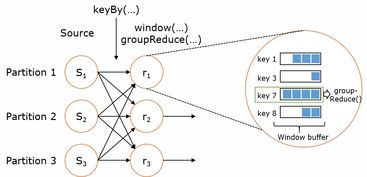

数据流模型是一种描述数据流系统中数据传输和处理过程的模型。它包括数据源、数据流通道、数据处理单元和数据接收器等组成部分。数据源负责生成数据元素,并将它们发送到数据流通道中。数据处理单元对接收到的数据进行处理,并将结果发送到数据接收器中。数据接收器负责将处理后的数据存储或输出。

3. 数据流分析原理

数据流分析是基于数据流模型的一种处理方法,它通过对数据流中的数据进行处理和分析,提取出有用的信息和知识。与传统的批处理方法不同,数据流分析具有实时性、动态性和适应性的特点。它能够处理不断变化的数据流,并及时地输出分析结果。

4. 数据流分析算法

数据流分析算法是一系列用于数据流处理的算法,包括聚类、分类、关联规则挖掘、异常检测等。这些算法能够对数据流中的数据进行深入的分析和处理,提取出有用的信息和知识。与传统的批处理算法不同,数据流算法需要考虑实时性和计算资源限制等问题,因此需要采用一些特殊的优化方法和技术。

5. 数据流分析应用

数据流分析在各个领域都有广泛的应用,包括金融、医疗、社交网络、电子商务等。例如,在金融领域,可以利用数据流分析来监测和预测股票价格、货币汇率等金融指标的变化;在医疗领域,可以利用数据流分析来监测病人的生命体征和病情变化,并及时采取相应的治疗措施;在社交网络和电子商务领域,可以利用数据流分析来分析用户的兴趣和行为模式,为营销和个性化推荐提供支持。

6. 数据流分析未来发展

随着大数据和人工智能技术的不断发展,数据流分析将会在未来发挥更加重要的作用。未来,数据流分析将会朝着以下几个方向发展:

(1)高性能计算:随着计算资源的不断提升和优化,未来可以利用更加高效的并行计算和分布式计算技术来提高数据流处理的性能和效率。

(2)深度学习:深度学习技术可以进一步扩展数据流分析的应用范围和提高分析的精度。例如,可以利用深度学习模型对图像、语音等非结构化数据进行处理和分析。

(3)隐私保护:随着大数据的广泛应用,隐私保护问题越来越受到关注。未来需要研究如何在保证隐私安全的前提下进行有效的数据流分析。

(4)可解释性:为了提高用户对模型预测结果的信任度,未来需要研究可解释性强的模型,解释模型做出相应决策的原因。

7. 结论

数据流分析是大数据时代的重要技术之一,它具有实时性、动态性和适应性的特点,能够处理不断变化的数据流并及时输出分析结果。未来,随着高性能计算、深度学习、隐私保护和可解释性等方面的不断发展和改进,数据流分析将会在各个领域发挥更加重要的作用。